Теоретическая часть: особенности архитектуры

Компания Nvidia не останавливается на достигнутом, продолжая поток анонсов новых моделей видеокарт семейства GeForce RTX 30, основанных на архитектуре Ampere. Они отличаются от аналогичных видеокарт архитектуры Turing тем, что дают заметно более высокую производительность за ту же цену. Благодаря оптимизации и производству по более тонкому техпроцессу, игровые решения новой архитектуры примерно в полтора раза быстрее аналогичных Turing в традиционных задачах растеризации и до двух раз быстрее при трассировке лучей. Новая серия предлагает значительное улучшение соотношения цены и производительности по сравнению с семейством GeForce RTX 20.

Мы уже рассмотрели три игровые видеокарты архитектуры Ampere, анонсированные во время виртуального мероприятия еще в начале сентября, когда были представлены сразу три модели: RTX 3070, RTX 3080 и RTX 3090. Две дорогие видеокарты основаны на разных модификациях чипа GA102, а младшая из тройки базируется на графическом процессоре GA104, стоящем на шаг ниже GA102. Но Nvidia нужны еще более доступные варианты для продвижения на рынке, а менее сложных чипов они пока что не сделали. Поэтому решили выпустить модель RTX 3060 Ti, основанную на том же чипе GA104, но еще больше урезанном по количеству исполнительных блоков.

Напомним, что этот GPU средней мощности поддерживает все особенности и технологии старшего чипа, и модели RTX 3070 с RTX 3060 Ti отличаются от RTX 3080 с RTX 3090 разве что применением типа памяти GDDR6, а не новой GDDR6X, которая просто не нужна более слабым решениям, да и слишком дорога для решений этого ценового диапазона. Предварительные данные о производительности новинки говорят о том, что целью Nvidia было получение производительности GeForce RTX 2080 Super из предыдущего поколения, но уже по совсем другой цене — всего лишь $399 (чуть меньше 40 тысяч рублей).

Посмотрите на показатели GeForce RTX 3060 Ti в тестах от самой Nvidia — все они заметно выше, чем у модели RTX 2060 Super из семейства Turing, и даже несколько превосходят показатели RTX 2080 Super! К слову, нам обещают также и то, что RTX 3060 Ti обеспечит производительность, достаточную для комфортной игры в Cyberpunk 2077 с включенной трассировкой лучей с ультра-качеством, пусть и всего лишь в Full HD-разрешении.

По диаграмме видно, что в играх с применением растеризации и трассировки лучей, новинка имеет явное преимущество перед моделью, последователем ценового диапазона которой она является — GeForce RTX 2060 Super. Разница между ними достигает полутора раз в пользу новой видеокарты. Новая модель обеспечивает скорость чуть выше, чем у RTX 2080 Super архитектуры Turing с более высокой ценой. А в приложениях для создания 3D-контента RTX 3060 Ti дает в 1,6–1,8 раза более высокую производительность, по сравнению с RTX 2060 Super, да и RTX 2080 Super также остается далеко позади.

Основой рассматриваемой сегодня модели видеокарты стала очередная версия графического процессора архитектуры Ampere, и так как она имеет достаточно много общего с предыдущими архитектурами Turing и Volta, то перед прочтением материала мы советуем ознакомиться и с нашими предыдущими статьями:

| Графический ускоритель GeForce RTX 3060 Ti | |

|---|---|

| Кодовое имя чипа | GA104 |

| Технология производства | 8 нм (Samsung »8N Nvidia Custom Process») |

| Количество транзисторов | 17,4 млрд |

| Площадь ядра | 392,5 мм² |

| Архитектура | унифицированная, с массивом процессоров для потоковой обработки любых видов данных: вершин, пикселей и др. |

| Аппаратная поддержка DirectX | DirectX 12 Ultimate, с поддержкой уровня возможностей Feature Level 12_2 |

| Шина памяти | 256-битная: 8 независимых 32-битных контроллеров памяти с поддержкой памяти типа GDDR6 |

| Частота графического процессора | до 1655 МГц |

| Вычислительные блоки | 38 потоковых мультипроцессоров (из 48 в полном чипе), включающих 4864 CUDA-ядер (из 6144 ядер) для целочисленных расчетов INT32 и вычислений с плавающей запятой FP16/FP32/FP64 |

| Тензорные блоки | 152 тензорных ядра (из 192) для матричных вычислений INT4/INT8/FP16/FP32/BF16/TF32 |

| Блоки трассировки лучей | 38 RT-ядер (из 48) для расчета пересечения лучей с треугольниками и ограничивающими объемами BVH |

| Блоки текстурирования | 152 блока (из 192) текстурной адресации и фильтрации с поддержкой FP16/FP32-компонент и поддержкой трилинейной и анизотропной фильтрации для всех текстурных форматов |

| Блоки растровых операций (ROP) | 10 широких блоков ROP на 80 пикселей с поддержкой различных режимов сглаживания, в том числе программируемых и при FP16/FP32-форматах буфера кадра |

| Поддержка мониторов | поддержка HDMI 2.1 и DisplayPort 1.4a (со сжатием DSC 1.2a) |

| Спецификации референсной видеокарты GeForce RTX 3060 Ti | |

|---|---|

| Частота ядра | до 1655 МГц |

| Количество универсальных процессоров | 4864 |

| Количество текстурных блоков | 152 |

| Количество блоков блендинга | 80 |

| Эффективная частота памяти | 14 ГГц |

| Тип памяти | GDDR6 |

| Шина памяти | 256-бит |

| Объем памяти | 8 ГБ |

| Пропускная способность памяти | 448 ГБ/с |

| Вычислительная производительность (FP32) | до 16,1 терафлопс |

| Теоретическая максимальная скорость закраски | 132 гигапикселя/с |

| Теоретическая скорость выборки текстур | 252 гигатекселя/с |

| Шина | PCI Express 4.0 |

| Разъемы | один HDMI 2.1 и три DisplayPort 1.4a |

| Энергопотребление | до 200 Вт |

| Дополнительное питание | один 8-контактный разъем |

| Число слотов, занимаемых в системном корпусе | 2 |

| Рекомендуемая цена | $399 (39 990 рублей) |

Наименование очередной модели из нового поколения соответствует принципу наименования решений Nvidia, она стала первой видеокартой семейства с суффиксом Ti, означающим промежуточное положение между RTX 3070 и… будущей RTX 3060, вероятно. Понятно, что RTX 3070 стоит в линейке выше нее, а ниже из Ampere пока что ничего нет. Рекомендованная цена для GeForce RTX 3060 Ti составляет $399, а вот ценовая рекомендация для нашего рынка слегка поправлена в сторону повышения — 39990 рублей.

Получается условный курс 100 рублей за доллар (и с учетом налога в 20% это вполне нормально), но для RTX 3070 он был несколько меньше — $499 и 45490 рублей, то есть условный курс был 91,2 руб. Впрочем, при нынешней ситуации, с учетом падения курса национальной валюты и дефицитом абсолютно всех новых решений, связанным как с повышенным интересом покупателей, так и с ограниченными поставками, рекомендованная цена новинки не выглядит слишком завышенной. Все равно реальная будет еще выше — по крайней мере, поначалу. В том числе и потому, что новинка является самой доступной среди всех Ampere и явно получит наибольший интерес со стороны покупателей.

Тем более, что у RTX 3060 Ti на рынке сейчас нет конкурентов, разве что модели предыдущего поколения, покупка которых явно потеряла смысл, так как Ampere имеет свои преимущества, включая высокую производительность при трассировке лучей и новые технологии (взять тот же HDMI 2.1). Да и от конкурентов в виде компании AMD на рынке пока что ничего нет. Хотя они выпустили новые решения для более высоких ценовых сегментов, ниже у них есть разве что пара Radeon RX 5700 (XT), которые являются решениями явно более низкого уровня. Продолжаем ждать видеокарт на базе архитектуры RDNA 2, способных конкурировать с GeForce RTX 3060 Ti по цене.

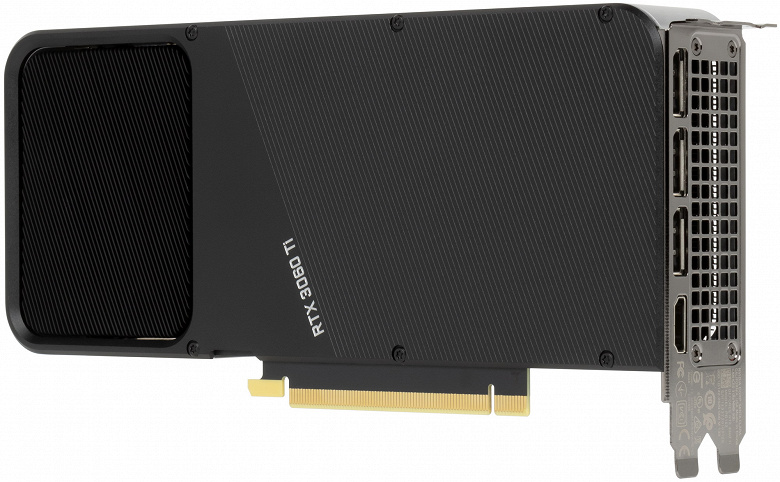

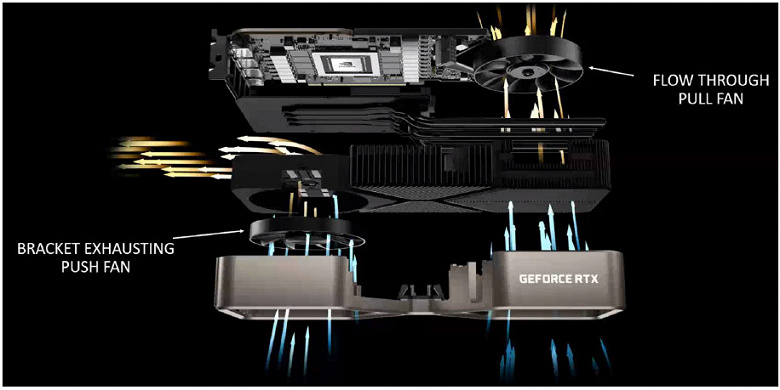

Аналогично предыдущим моделям, компания Nvidia предлагает и собственный вариант RTX 3060 Ti Founders Edition, который практически полностью совпадает с таковым для RTX 3070 FE. Эти видеокарты предлагают интересные системы охлаждения и строгий дизайн, которого не найти у большинства производителей видеокарт. GeForce RTX 30, продаваемые под собственным брендом Nvidia, отличаются совершенно новым дизайном системы охлаждения с двумя вентиляторами, один из которых привычно выдувает воздух через решетку с торца платы, а второй протягивает воздух прямо сквозь видеокарту. В отличие от старших моделей, у RTX 3060 Ti оба вентилятора установлены с лицевой стороны карты, как и у RTX 3070, но принцип работы у всех одинаковый.

В результате RTX 3060 Ti FE предлагает тихую и эффективную систему охлаждения, неплохо сочетающуюся с большинством систем охлаждения в имеющихся ПК. Тепло отводится от различных компонентов на карте к радиатору, левый вентилятор выводит нагретый воздух через большие вентиляционные отверстия в рамке видеокарты, а правый направляет воздух к выдувному вентилятору в верхней части корпуса, где он обычно установлен в большинстве современных систем.

Младшая модель семейства GeForce RTX 30 также использует новый формат 12-контактного разъема питания, позволяющий компактнее разместить некоторые элементы на карте, разве что переходник к ней отличается подключением к единственному 8-контактному кабелю от БП, а не к двум, как у старших моделей. Потребление энергии у RTX 3060 Ti чуть ниже, чем у старшей сестры на том же GPU, но разница невеликая — 200 Вт против 220 Вт.

Видеокарты модели GeForce RTX 3060 Ti должны появиться в продаже со 2 декабря, но в связи с недостаточным объемом производства, огромным спросом и дефицитом видеокарт семейства GeForce RTX 30, сложно что-то утверждать с точностью. Скорее всего, новинку явно еще придется поискать в продаже по хорошей цене. Естественно, партнеры компании сразу выпустили и карты собственного дизайна, ведь RTX 3060 Ti слабо отличается от RTX 3070.

Архитектурные особенности

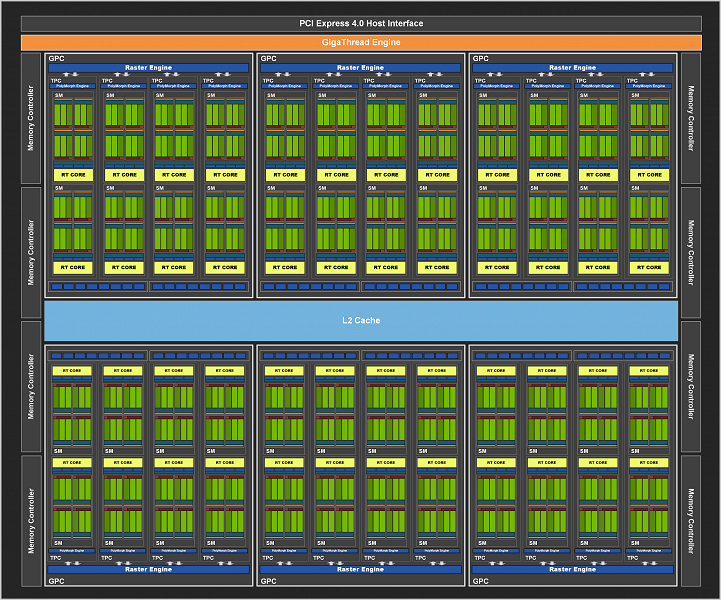

Как и все графические процессоры компании Nvidia, чип GA104 состоит из укрупненных кластеров Graphics Processing Cluster (GPC), которые включают несколько кластеров текстурной обработки Texture Processing Cluster (TPC), содержащих потоковые процессоры Streaming Multiprocessor (SM), блоки растеризации Raster Operator (ROP) и контроллеры памяти. Полный чип GA104, схему которого мы видим ниже, содержит шесть кластеров GPC и 48 мультипроцессоров SM. Каждый GPC содержит по четыре TPC, состоящих из пары SM и движка PolyMorph Engine для работы с геометрией.

Полная версия графического процессора GA104 содержит 6144 потоковых CUDA-ядра, 48 RT-ядер второго поколения и 192 тензорных ядра третьего поколения. Подсистема памяти GA104 включает восемь 32-битных контроллеров памяти, что дает 256-бит в общем. Каждый 32-битный контроллер связан с разделом кэш-памяти второго уровня объемом в 512 КБ, и общий объем L2-кэша получается равным 4 МБ. Вот диаграмма полной версии чипа:

Модель видеокарты GeForce RTX 3060 Ti использует еще более урезанный по количеству блоков вариант GA104, по сравнению с RTX 3070. Эта модификация получила лишь 38 активных блоков SM, меньше сразу на десяток — то есть, один GPC в чипе полностью отключен, а также в еще одном из GPC отключен один кластер TPC с парой мультипроцессоров SM. Соответственно, отличается и количество остальных блоков, и такой GPU имеет 4864 CUDA-ядра, 152 тензорных ядра и 38 RT-ядер. Текстурных блоков в этой модификации 152 штуки, а количество блоков ROP в ней урезано до 80, в отличие от 96 в старшем варианте GPU.

RTX 3060 Ti имеет 8 ГБ GDDR6-памяти, известной по предыдущим поколениям GPU, в отличие от новой GDDR6X, применяемой лишь в двух старших моделях. Память у RTX 3060 Ti подключена по полной 256-битной шине, что дает 448 ГБ/с пропускной способности — ровно как у RTX 3070. Да и объем видеопамяти у них одинаковый — 8 ГБ. Для видеокарт такого уровня этого вполне достаточно, с учетом их мощности и ценового диапазона. Тем более, что игры даже в 4K-разрешении при максимальных настройках до сих пор не требуют большего объема памяти, хотя и могут занять всю имеющуюся VRAM.

Например, такие игры как The Division 2 или последние части Call of Duty, могут занимать всю имеющуюся видеопамять — на всякий случай полностью забивая ее своими ресурсами. То есть, на видеокарте с 8 ГБ памяти, вроде RTX 2080 Super, и на RTX 2080 Ti с 11 ГБ памяти в этой игре в 4K-разрешении при ультра-настройках будет показываться, что заняты 7,5–8 ГБ и 10,5–11 ГБ соответственно, но производительность на видеокарте с меньшим объемом видеопамяти при этом страдать не будет. А конкретно для RTX 3060 Ti 8 ГБ — это идеальный объем видеопамяти, большего ей просто не нужно.

Подробно рассматривать архитектурные улучшения Ampere в этой статье мы не будем, все уже было написано в теоретическом материале по GeForce RTX 3080. Основным нововведением Ampere является удвоение FP32-производительности для каждого мультипроцессора SM, по сравнению с семейством Turing, что привело к значительному повышению пиковой производительности. Почти то же самое касается и RT-ядер — хотя их число и не изменилось, внутренние улучшения привели к удвоению темпа поиска пересечений лучей с геометрией. Улучшенные тензорные ядра хоть и не увеличили производительность при обычных условиях, но темп таких вычислений удвоился, а также появилась возможность удвоения скорости обработки так называемых разреженных матриц.

Все остальные архитектурные особенности игровых решений Ampere, включая изменения в мультипроцессорах SM, блоках ROP, системе кэширования и текстурирования, тензорных и RT-ядрах, подробно рассмотрены в теоретическом обзоре RTX 3080. Все эти улучшения привели к достижению довольно высокой энергоэффективности, вся архитектура Ampere делалась с упором на это, включая доработанный техпроцесс Samsung, дизайн чипов и печатных плат, оптимизацию ПО и многое другое. Что получилось у Nvidia конкретно в случае RTX 3060 Ti — мы узнаем в практических частях материала.

Добавим лишь пару строк о поддержке стандарта вывода изображения HDMI 2.1 и аппаратного декодирования видеоданных в формате AV1. Они поддерживаются всей серией GeForce RTX 30, HDMI 2.1 позволяет подключить устройства с 4K-разрешением и частотой обновления в 120 Гц, а аппаратный декодер AV1 обеспечивает просмотр онлайн-видео в лучшем качестве, по сравнению с известными форматами, вроде H.264, HEVC и VP9.

Программные технологии

Сначала поговорим о новых возможностях для разгона. Как бы в ответ на режим авторазгона Rage Mode, появившийся в топовых решениях конкурента, компания Nvidia выкатила свой аналог, разработка которого давно шла, просто она не появлялась в настройках драйвера и утилиты GeForce Experience. Это типичная система простого автоматического разгона, позволяющая немного повысить производительность системы в играх и других приложениях, которые ограничены именно возможностями GPU.

Функция GPU Tuning появилась в бета-версии GeForce Experience со времен выпуска первых решений GeForce RTX 30 в сентябре. Для того, чтобы воспользоваться системой авторазгона в оверлее GFE, самостоятельно увеличивающей предел потребления энергии и использующей кривую напряжений и частот, уникальную для каждого конкретного GPU, нужно включить экспериментальные функции в настройках GFE, обновить приложение, включить оверлей и затем нажать Alt+Z для его вызова. В нем выбрать «Performance» и нажать «Enable Automatic Tuning», а дальше утилита самостоятельно все сделает, что займет какое-то время.

Мы рассмотрим работу авторазгона позднее, а сейчас переходим к играм. Почти все самые значимые и долгожданные игры из современных проектов уже поддерживают трассировку лучей, это Cyberpunk 2077, Watch Dogs Legion, Call of Duty: Black Ops Cold War и многие другие свежие релизы. В будущем их станет только больше, так как теперь и видеокарты AMD Radeon и новые консоли поддерживают трассировку, пусть и в несколько менее эффективном виде.

Добавьте к ним популярные проекты вроде Fortnite, Minecraft и World of Warcraft, которые также предлагают разную степень поддержки трассировки лучей для реализации таких эффектов, как отражения, тени, рассеянное затенение, глобальное освещение и даже полную трассировку пути, полностью раскрывающую возможности современных графических процессоров с аппаратной поддержкой трассировки лучей — как в бета-версии Minecraft с поддержкой трассировки лучей, которая обновилась, а также в нее были добавлены новые RTX-миры.

Так как трассировка лучей это весьма ресурсоемкое дело, то игры зачастую поддерживают метод повышения производительности Nvidia DLSS для того, чтобы достичь комфортной производительности. Поддержка технологии DLSS уже есть в 26 играх, включая с десяток проектов, вышедших в последние пару месяцев, и этот список явно продолжит расширяться.

Например, свежая игра Watch Dogs Legion от Ubisoft использует трассировку лучей для отрисовки корректных отражений, с которыми отлично смотрится мрачный виртуальный Лондон с его лужами и зданиями из стекла и металла. А еще одна новая игра Call of Duty: Black Ops Cold War использует трассировку лучей для отрисовки всех теней и реализации качественного рассеянного затенения (ambient occlusion). Обе игры также поддерживают и Nvidia DLSS — для улучшения производительности в высоких разрешениях.

Не забывают в Nvidia и о вышедших ранее играх — не так давно поддержку современных технологий компании получила и одна из самых популярных игр — Fortnite. В ней появились такие эффекты с применением трассировки лучей, как отражения, тени, рассеянное затенение и глобальное освещение. Также поддерживаются технологии DLSS и Reflex, помогающие повысить производительность и комфорт при игре.

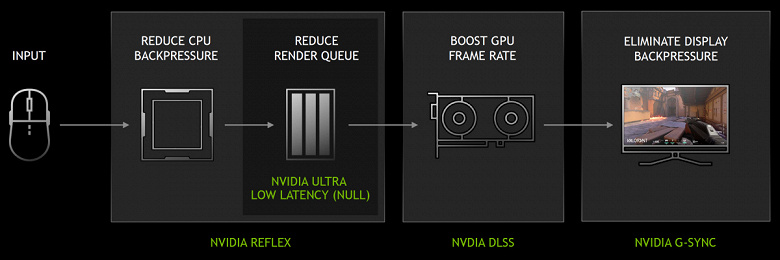

Вместе с архитектурой Ampere компания Nvidia представила технологию Reflex, которая предназначена для минимизации задержек при игре в киберспортивные игры. Новый набор технологий, оптимизирующих и измеряющих задержки системы, предназначен для того, чтобы улучшить реакцию ПК на действия игроков. Технология Reflex Low-Latency, встроенная в 11 популярных киберспортивных игр, вроде Apex Legends, Call of Duty: Warzone, Destiny 2, Fortnite и Valorant, значительно снижает задержки.

Причем, технология Reflex не является уникальной только для решений на базе архитектуры Ampere, а работает на всех видеокартах компании Nvidia, начиная с серии GeForce GTX 900. Собственно, у Nvidia уже есть целый набор технологий, предназначенных для снижения задержек и улучшения комфорта при игре, это Reflex, DLSS и G-Sync — все они работают в связке и обеспечивают максимальную плавность и точность:

В киберспортивных состязаниях низкая задержка и лучшая отзывчивость системы приводит к лучшим результатам и победам, ведь там важна каждая миллисекунда. Более низкие системные задержки означают лучшую отзывчивость, и это ощущается даже лучше, чем высокая частота кадров. Снижение задержек приводит к улучшению точности прицеливания в играх, что вполне логично.

Reflex — технология для снижения системной задержки, сочетающая оптимизации со стороны графического процессора и игр. В случаях, когда производительность ограничена графическим процессором, Reflex SDK позволяет CPU начать передачу работы по рендерингу в GPU сразу перед тем, как он завершит предыдущий кадр, что значительно сокращает, а зачастую и вовсе устраняет очередь рендеринга. Хотя это и похоже на режим сверхнизкой задержки в драйвере, он работает лучше, так как этот метод работает в самом игровом движке.

Nvidia Reflex SDK интегрируется или уже встроен во все популярные киберспортивные игры. Применение Reflex SDK также позволяет повысить частоты GPU для быстрого расчета и вывода подготовленных кадров на экран чуть раньше обычного — в некоторых случаях, когда общая производительность ограничена скоростью центрального процессора. Эта возможность аналогична ранее известной функции «Prefer Maximum Performance», доступной из панели настроек драйверов Nvidia.

Наиболее заметное снижение задержек будет наблюдаться в сценариях, когда общее время рендеринга ограничено мощностью GPU, то есть в высоких разрешениях и при максимальных графических настройках, когда очереди рендеринга велики. GPU средней мощности, вроде GTX 1660 Super, получают приличное снижение задержек в Full HD-разрешении, даже по сравнению с технологией Nvidia Ultra Low Latency (NULL), а для мощных видеокарт типа RTX 30, технология Reflex позволяет насладиться высоким разрешением рендеринга без соответствующих потерь в отзывчивости, которые обычно наблюдаются при росте разрешения.

На диаграмме выше приведены замеры задержек на системе с 4K-монитором с частотой обновления 144 Гц и видеокартой GeForce RTX 3070, которая очень близка к рассматриваемой сегодня RTX 3060 Ti. Использовались максимальные настройки без трассировки лучей, для NULL выбран уровень Ultra, а для DLSS — режим Performance. Как видите, сочетание нескольких технологий компании позволило более чем вдвое снизить системные задержки, что может обеспечить очень серьезное преимущество при игре.

Ну, а технология Reflex Latency Analyzer определяет входной сигнал с мыши и измеряет время до появления результата на экране — без необходимости использования специального оборудования вроде скоростных камер, как это было необходимо ранее. Эта технология встроена в новые 360-герцовые дисплеи Nvidia G-Sync Esports, которые появились этой осенью у компаний Acer, Alienware, Asus и MSI. Она поддерживается и в периферийных устройствах производства компаний Asus, Logitech, Razer и SteelSeries и позволяет оценить реальные задержки при игре.

Особенности видеокарты Nvidia GeForce RTX 3060 Ti Founders Edition

Сведения о производителе: Компания Nvidia Corporation (торговая марка Nvidia) основана в 1993 году в США. Штаб-квартира в Санта-Кларе (Калифорния). Разрабатывает графические процессоры, технологии. До 1999 года основной маркой была Riva (Riva 128/TNT/TNT2), с 1999 года и по настоящее время — GeForce. В 2000 году были приобретены активы 3dfx Interactive, после чего торговые марки 3dfx/Voodoo перешли к Nvidia. Своего производства нет. Общая численность сотрудников (включая региональные офисы) — около 5000 человек.

Установка такой крохотули в тестовый стенд

Объект исследования: ускоритель трехмерной графики (видеокарта) Nvidia GeForce RTX 3060 Ti Founders Edition 8 ГБ 256-битной GDDR6

Характеристики карты

| Nvidia GeForce RTX 3060 Ti Founders Edition 8 ГБ 256-битной GDDR6 | |

|---|---|

| GPU | GeForce RTX 3060 Ti (GA104) |

| Интерфейс | PCI Express x16 4.0 |

| Частота работы GPU (ROPs), МГц | 1440—1665(Boost)—2010(Max) |

| Частота работы памяти (физическая (эффективная)), МГц | 3500 (14000) |

| Ширина шины обмена с памятью, бит | 256 |

| Число вычислительных блоков в GPU | 38 |

| Число операций (ALU/CUDA) в блоке | 128 |

| Суммарное количество блоков ALU/CUDA | 4864 |

| Число блоков текстурирования (BLF/TLF/ANIS) | 152 |

| Число блоков растеризации (ROP) | 80 |

| Число блоков Ray Tracing | 38 |

| Число тензорных блоков | 152 |

| Размеры, мм | 240×100×36 |

| Количество слотов в системном блоке, занимаемые видеокартой | 2 |

| Цвет текстолита | черный |

| Энергопотребление пиковое в 3D, Вт | 202 |

| Энергопотребление в режиме 2D, Вт | 30 |

| Энергопотребление в режиме «сна», Вт | 11 |

| Уровень шума в 3D (максимальная нагрузка), дБА | 29,5 |

| Уровень шума в 2D (просмотр видео), дБА | 18,0 |

| Уровень шума в 2D (в простое), дБА | 18,0 |

| Видеовыходы | 1×HDMI 2.1, 3×DisplayPort 1.4a |

| Поддержка многопроцессорной работы | нет |

| Максимальное количество приемников/мониторов для одновременного вывода изображения | 4 |

| Питание: 8-контактные разъемы | 1 (12-контактный) c адаптером на 8-контактный разъем |

| Питание: 6-контактные разъемы | 0 |

| Максимальное разрешение/частота, Display Port | 7680×4320@60 Гц |

| Максимальное разрешение/частота, HDMI | 7680×4320@60 Гц |

| Ожидаемая розничная стоимость карты | около 42 тысяч рублей на момент подготовки обзора |

Память

Карта имеет 8 ГБ памяти GDDR6 SDRAM, размещенной в 8 микросхемах по 8 Гбит на лицевой стороне PCB. Микросхемы памяти Samsung (GDDR6, K4Z80325BC-HC14) рассчитаны на условную номинальную частоту работы в 3500 (14000) МГц.

Особенности карты и сравнение с Nvidia GeForce RTX 3070 Founders Edition

| Nvidia GeForce RTX 3060 Ti Founders Edition 8 ГБ | Nvidia GeForce RTX 3070 Founders Edition 8 ГБ |

|---|---|

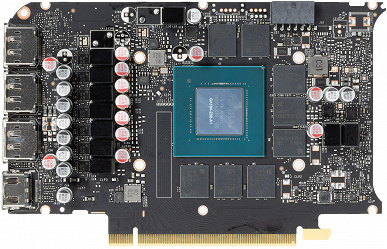

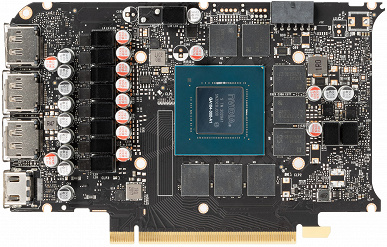

| вид спереди | |

|

|

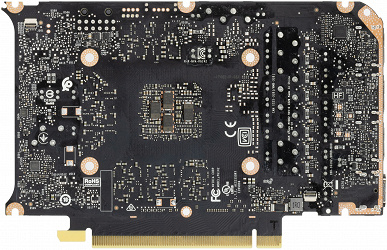

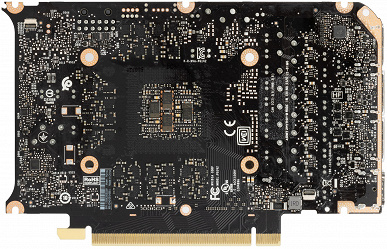

| вид сзади | |

|

|

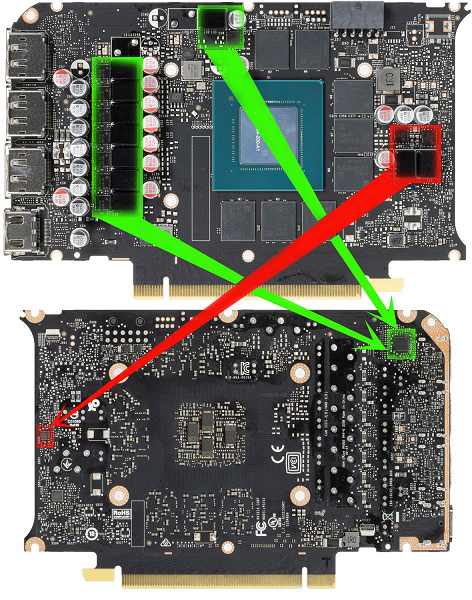

Очевидно, что сравнивать новый продукт логичнее всего с его…ну скажем так, родителем, ведь RTX 3060 Ti основан на том же по сути GPU, что и RTX 3070, лишь урезаны некоторые блоки. Да и прекрасно видно, что PCB одна и та же у обеих видеокарт. Отличия есть только в наличии/отсутствии некоторых элементов в системе питания.

Хорошо известно, что для семейства GeForce RTX 30 в компании Nvidia был разработан кардинально новый референс-дизайн, и в данном случае мы видим дальнейшее развитие эталонного дизайна для продуктов, имеющих более простую компоновку, всего 8 микросхем памяти и систему питания попроще. Как и в случае с GeForce RTX 3090/3080 и GeForce RTX 3070, в Nvidia сделали два варианта дизайна PCB: для своих карт Founders Edition и для партнеров. Оба варианта отличаются приличной компактностью.

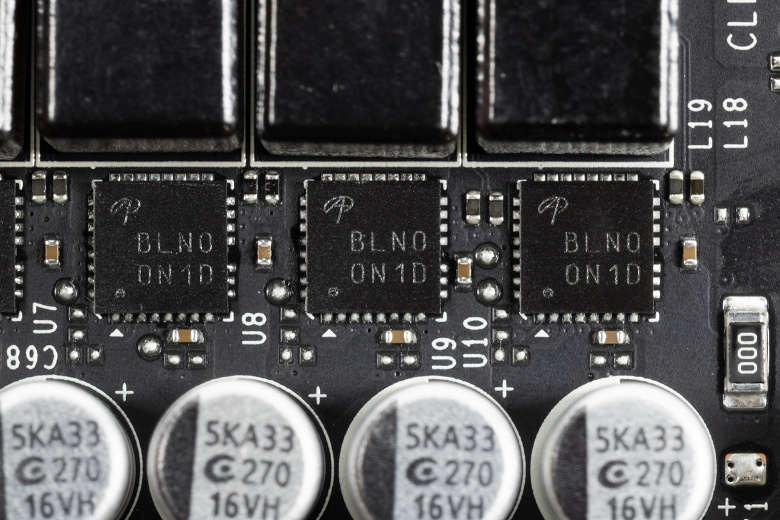

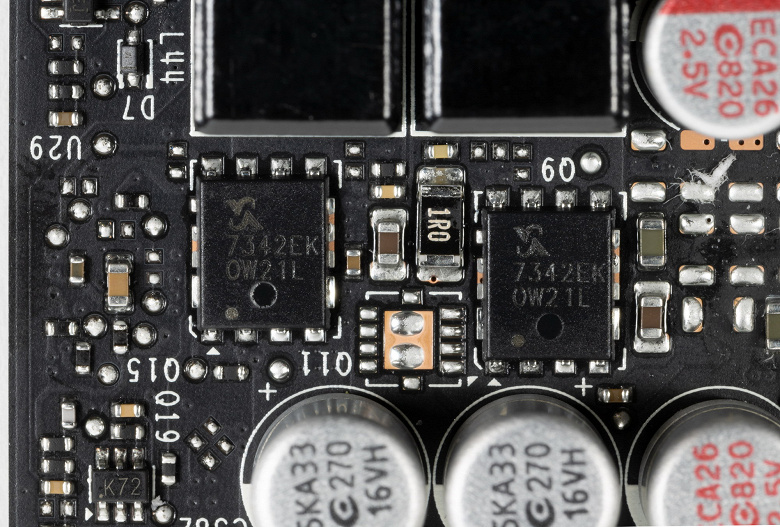

Суммарное количество фаз питания у GeForce RTX 3060 Ti — 10 (это на 1 меньше, чем у GeForce RTX 3070: убрали самую верхнюю фазу слева). При этом распределение фаз у GeForce RTX 3070 — 9 фаз на ядро и 2 на микросхемы памяти, а у GeForce RTX 3060 Ti — 8+2. Ранее было одно пустое место под дополнительную фазу (на самом верху печатной платы), теперь стало два.

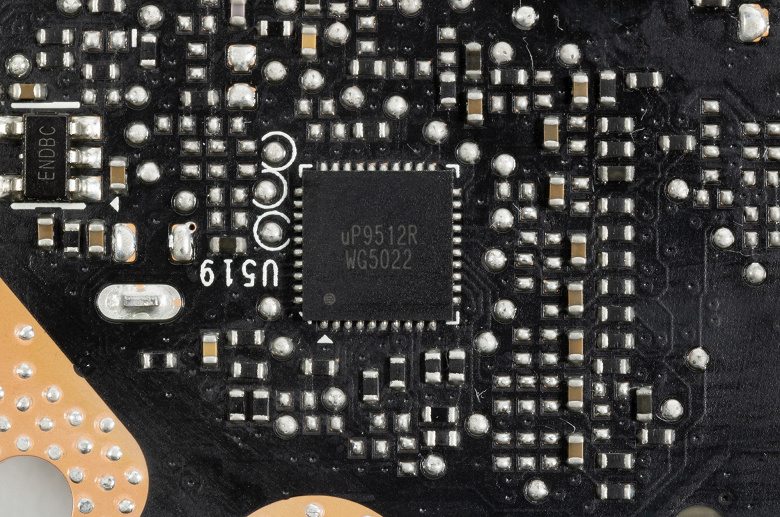

Зеленым цветом отмечена схема питания ядра, красным — памяти. ШИМ-контроллер: uP9512R (uPI Semiconductor) отвечает за работу фаз питания графического процессора.

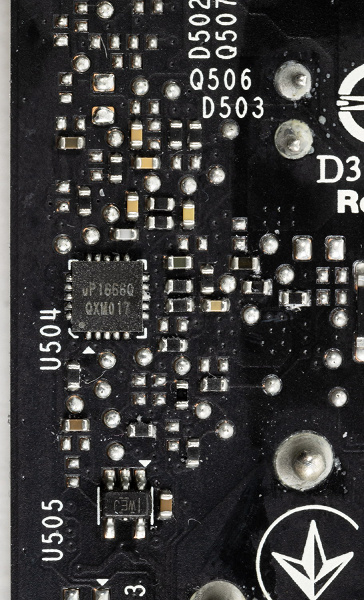

А контроллер uP1666Q управляет двумя фазами питания микросхем памяти. Оба контроллера расположены на обороте печатной платы.

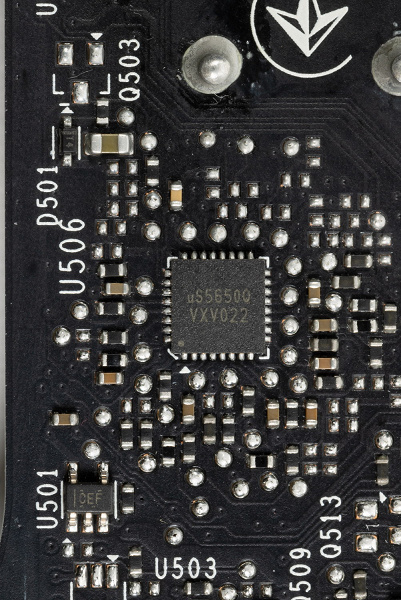

На лицевой стороне имеется uS5650Q (той же uPI), отвечающий за мониторинг.

В материале по RTX 3070 мы ошиблись в распределении работ у ШИМ-контроллеров, все же верной является вышепредставленная схема.

В преобразователе питания, традиционно для всех видеокарт Nvidia, используются транзисторные сборки DrMOS — в данном случае мосфеты схемы питания GPU AOZ5311NGI (Alpha&Ω Semiconductor) и мосфеты схемы питания памяти SM7342EKKP (Sinopower).

Как и у предыдущих карт Founders Edition серии GeForce RTX 30, у этой карты 12-контактный коннектор питания. Все сравнения карт FE есть в начальном видеоролике.

Ранее уже было известно, что ряд производителей блоков питания, прежде всего Seasonic, объявили о выпуске отдельных кабелей («хвостов») для своих модульных БП для подключения к референс-картам серии GeForce RTX 30. А с самой картой, конечно же, поставляется переходник, позволяющий подключить 8-контактный коннектор к новому разъему.

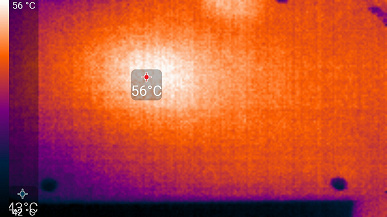

Нагрев и охлаждение

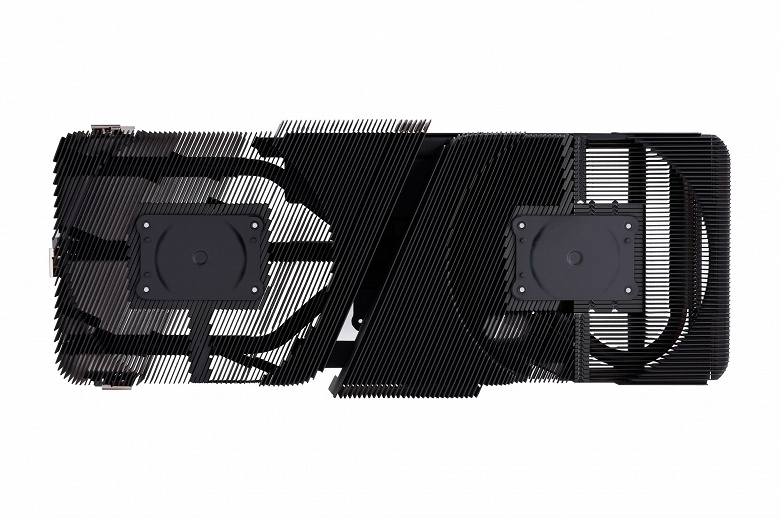

Мы уже много раз писали, что PCB у новых карт Founders Edition стала более компактной, ведь для таких карт была задумана специальная система охлаждения.

Эта схема едина для карт всей серии, хотя в случае GeForce RTX 3070 и 3060 Ti в дизайне имеются некоторые нюансы.

Основной пластинчатый радиатор, выполненный из медного сплава, имеет тепловые трубки, подведенные к теплосъемнику на GPU.

Массивная основа (рама) охлаждает также микросхемы памяти и преобразователи питания VRM. Задняя пластина участвует в охлаждении оборотной стороны PCB.

Вентиляторов здесь два (∅90 мм), в обоих используются двойные подшипники. Особенность данной СО состоит в том, что вентиляторы установлены уже не с разных сторон радиатора (см. схему выше), а с одной.

Однако изначальный замысел сохранился: правый вентилятор продувает радиатор (ту его часть, куда выведены тепловые трубки) насквозь (через решетку на оборотной стороне). Нагретый воздух остается в корпусе (при типовой установке видеокарты он выдувается вверх), и его должен подхватить вытяжной вентилятор в корпусе системного блока. Левый же вентилятор сразу выдувает горячий воздух за пределы корпуса сквозь отверстия в брекете карты.

Напомним, что обычно видеокарты останавливают свои вентиляторы в простое, при работе в 2D, если температура GPU опускается ниже примерно 60 градусов, и СО при этом становится бесшумной. В случае карт Nvidia GeForce RTX 3070/3060 Ti Founders Edition режим работы кулера иной: для остановки вентиляторов температура GPU должна быть ниже 50 °C, а энергопотребление самого GPU — ниже 30 Вт. Только при соблюдении всех условий вентиляторы остановятся. Ниже есть видеоролик на эту тему, где в конце вентиляторы все же останавливаются (но ждать надо весьма долго).

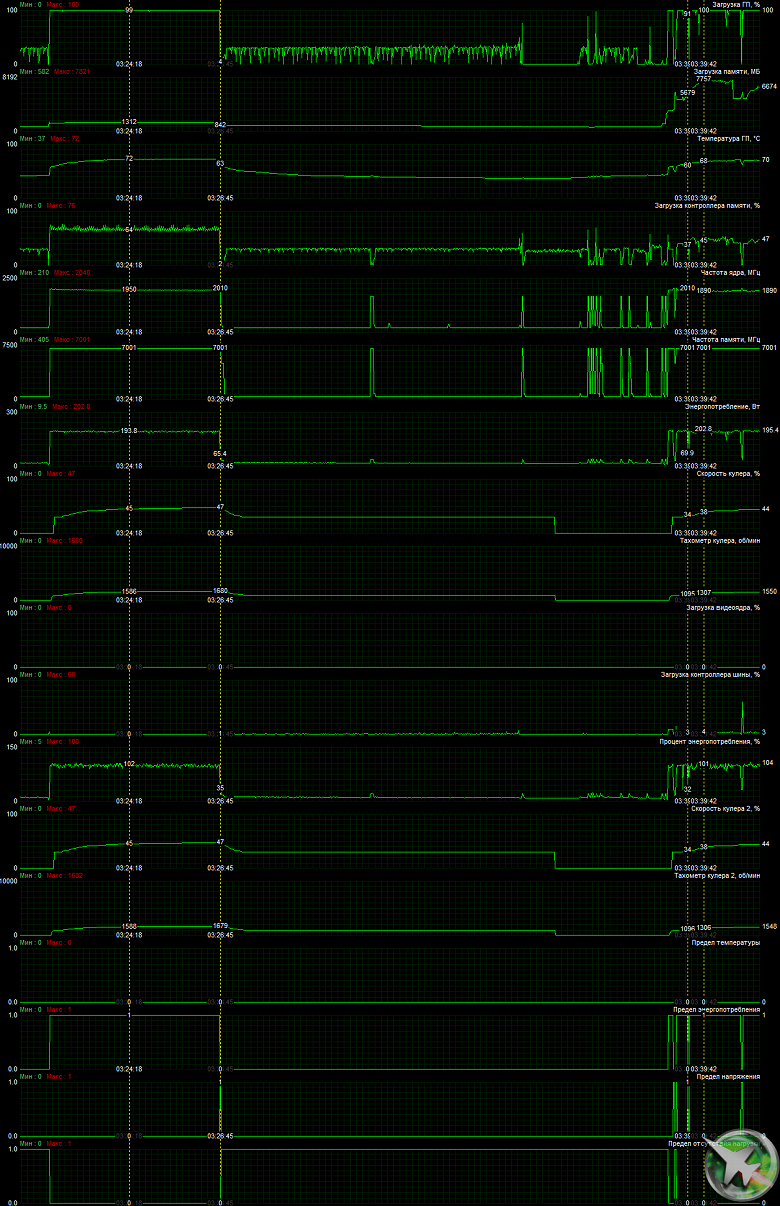

Мониторинг температурного режима с помощью MSI Afterburner:

После 6-часового прогона под нагрузкой максимальная температура ядра не превысила 72 градусов, что является приемлемым результатом для видеокарты такого уровня. Энергопотребление достигло уровня 202 Вт (в основном колебалось около 200 Вт).

Мы засняли и ускорили в 50 раз 9-минутный прогрев:

Максимальный нагрев наблюдался в районе преобразователей питания.

Шум

Методика измерения шума подразумевает, что помещение шумоизолировано и заглушено, снижены реверберации. Системный блок, в котором исследуется шум видеокарт, не имеет вентиляторов, не является источником механического шума. Фоновый уровень 18 дБА — это уровень шума в комнате и уровень шумов собственно шумомера. Измерения проводятся с расстояния 50 см от видеокарты на уровне системы охлаждения.

Режимы измерения:

- Режим простоя в 2D: загружен интернет-браузер с сайтом iXBT.com, окно Microsoft Word, ряд интернет-коммуникаторов

- Режим 2D с просмотром фильмов: используется SmoothVideo Project (SVP) — аппаратное декодирование со вставкой промежуточных кадров

- Режим 3D с максимальной нагрузкой на ускоритель: используется тест FurMark

Оценка градаций уровня шума следующая:

- менее 20 дБА: условно бесшумно

- от 20 до 25 дБА: очень тихо

- от 25 до 30 дБА: тихо

- от 30 до 35 дБА: отчетливо слышно

- от 35 до 40 дБА: громко, но терпимо

- выше 40 дБА: очень громко

В режиме простоя в 2D температура была не выше 36 °C, вентиляторы не работали, уровень шума был равен фоновому — 18 дБА.

При просмотре фильма с аппаратным декодированием ничего не менялось, поэтому шум сохранялся на прежнем уровне.

В режиме максимальной нагрузки в 3D температура достигала 72 °C. Вентиляторы при этом раскручивались до 1680 оборотов в минуту, шум вырастал до 29,5 дБА: это тихо. В видеоролике ниже видно, как растет шум (шум фиксировался пару секунд через каждые 30 секунд).

С учетом того, какие компактные размеры имеет данная карта, шум можно считать мизерным.

Подсветка

Подсветки у карты нет в принципе.

Так что данная видеокарта может «светить» лишь отраженным светом 🙂

Комплект поставки и упаковка

Комплект поставки, кроме традиционного руководства пользователя, включает переходник питания на новый 12-контактный разъем с 8-контактного коннектора.

Опять же, как и у GeForce RTX 3080/3090/3070, очень понравилась стильная упаковка.

Тестирование: синтетические тесты

Конфигурация тестового стенда

Синтетические тесты проводились в закрытом, хорошо продуваемом корпусе. Все видеокарты работали на стандартных частотах в нашем наборе синтетики, который продолжает постоянно меняться, добавляются новые тесты, а некоторые устаревшие постепенно убираются. Мы бы хотели добавить еще примеры с вычислениями, но с этим есть определенные сложности. Постараемся расширить и улучшить набор синтетических тестов, и если у вас есть четкие и обоснованные предложения — напишите их в комментариях к статье или отправьте авторам.

Мы полностью отказались от ранее активно использовавшихся нами тестов RightMark3D, так как они устарели слишком сильно, и на столь мощных GPU или не запускаются вообще, или упираются в различные ограничители, не загружая работой блоки графического процессора и не показывая его истинную производительность. А вот синтетические Feature-тесты из набора 3DMark Vantage мы все еще оставили в полном составе, так как заменить их попросту нечем, хотя и они уже изрядно устарели.

Из более-менее новых бенчмарков мы начали использовать несколько примеров, входящих в DirectX SDK и пакет SDK компании AMD (скомпилированные примеры применения D3D11 и D3D12), а также несколько разнообразных те

Полный текст статьи читайте на iXBT