Долгие годы жесткие диски на 3,5″ пластинах были основными носителями данных в персональных компьютерах и серверах. На этом посту они сменили своих 5,25″-собратьев, причем когда-то применялись и в портативных компьютерах. Однако для последних были быстро придуманы еще более компактные модели — с пластинами диаметром 2,5″ и даже 1,8″: такие модели компактнее и экономичнее. Но не только эти факторы «подстегивали» миниатюризацию — уменьшение диаметра пластин благотворно сказывалось и на времени поиска информации, да и «раскрутить» их до высоких скоростей куда проще. Поэтому и серверные винчестеры высокой производительности быстро мигрировали на пластины по 2,8″ с сохранением старых корпусов, а затем освоили и 2,5″ — уже с их уменьшением. Более широкому распространению мини- и «микровинчестеров» (с пластинами 1,8″ и менее) мешало только одно — площадь поверхности круга пропорционально квадрату его диаметра, так что, при одинаковой плотности записи, «маленькие» пластины вмещают намного меньше информации, чем «большие». Однако только при одинаковой — рост плотности как раз и похоронил 5,25″, хотя в этот формат некоторые производители и пытались вдохнуть новую жизнь еще в конце 90-х годов прошлого века. В «нулевые» увеличение плотности записи продолжалось — казалось бы, осталось совсем чуть-чуть, чтобы повсеместно перейти на 2,5″. Две-три таких пластины укладываются в 10 мм толщины, для высокооборотистых или просто очень емких моделей можно использовать корпуса на 15 мм — главное «впихнуть» в них те несколько терабайт, которых достаточно пользователю персонального компьютера, а в серверах все равно используются дисковые массивы, так что ту же емкость в одинаковом объеме лучше «набирать» большим количеством менее емких винчестеров, нежели меньшим более «крупных» (в обоих смыслах). И все — можно переходить повсюду к новым универсальным форм-факторам, выбросив старые на свалку истории. Где уже, например, давно уже пылится 5,25″ полной высоты — для понимания размеров старых винчестеров на 5—40 МБ (это не опечатка), когда-то использовавшихся в ПК, просто тактично намекнем, что «стандартный» пятидюймовый отсек корпусов (в новых моделях уже не встречается, а раньше активно использовались для оптических приводов и тому подобного) имеет половинную высоту.

Однако казавшееся магистральным направление развития оказалось тупиком. Во-первых, порядка 10 лет назад из тени вышли твердотельные накопители. Заменить полностью и повсеместно все жесткие диски они не могут до сих пор, поскольку стоимость хранения информации на них выше — в те годы это было еще более ярко выражено. А вот борьба за производительность «механикой» оказалась проиграна сразу — и полностью. Также под нож быстро пошли микровинчестеры — ибо медленные, мелкие, да еще и вибрации боятся. 2,5″ модели пока еще продаются, но давно не развиваются — все меньшие уже исчезли физически. Единственные сферы применения, где жесткие диски не только сохраняют, но и наращивают присутствие — хранение больших объемов «холодных данных». А для этого лучше всего подходят 3,5″ пластины. И основанные на них винчестеры уже превратились из «накопителей для ПК» в комплектующие для NAS и систем хранения данных.

Старые прогнозы и новые реалии

Заметим, что результат конкуренции с SSD мог бы быть немного иным, если бы удалось сохранить «старые» темпы увеличения плотности записи — до двух порядков за десятилетие. А это и увеличение производительности (последовательные скорости растут при увеличении продольной плотности записи), и увеличение емкости каждой пластины на те же два порядка. В таких условиях можно было спокойно сокращать размеры накопителей и не слишком модернизировать внутреннее устройство винчестеров — просто регулярно меняем старые пластины и головы на новые и все: получаются новые модели, радикально превосходящие старые по всем потребительским характеристикам. При этом та же емкости росла во всех своих проявлениях: и максимальная, и минимальная — бюджетные модели использовали только одну пластину или даже одну ее сторону, но и этого вполне хватало.

Оставайся все по-прежнему, сейчас бы могли продаваться диски эдак на 100 ТБ, причем всего на 4–5 пластинах. Стоили бы такие долларов 400, а то и меньше — все-таки давно вылизанный до блеска и простой «воздушный дизайн». Массовому же потребителю подобные были бы просто… не нужны ввиду отсутствия потребности в подобных непаханых гектарах. Зато строители центров обработки информации и прочие работники IT-инфраструктуры смотрели бы в будущее с куда большим оптимизмом, чем сейчас. А в персоналках массово потреблялись бы модели на 5—20 ТБ — и не потому, что именно столько так уж нужно, а потому, что меньше бы и не получалось. Причем получалось бы столько как раз на 2,5″ пластинах, но с «быстрой» механикой (в 15 мм высоты это возможно) и на скоростях вращения в 10К+ об/мин — что полностью скомпенсировало бы негативное влияние миниатюризации на скорость. «Чисто ноутбучные» же модели тоже наверняка сохранились бы —, но стали бы сплошь однопластинными на 5 мм толщины.

Конкурировать с такими винчестерами твердотельным накопителям было бы сложновато. Понятно, что они все равно бы постепенно расширяли ареал своего обитания — из-за большей скорости и устойчивости к вибрациям. Однако сохранение ценового разрыва на уровне конца прошлого десятилетия не позволяло бы делать это быстро. На деле же он сократился — что в некоторых сегментах рынка привело к драматическим последствиям. Например, те же ноутбучные винчестеры — долгое время обеспечивающие огромный валовой (в штуках) сбыт, поскольку и сами ноутбуки давно уже стали доминирующим форм-фактором компьютеров. Сегодня подобные модели тоже пока выпускаются —, но развитие давно закончилось. Фактически сейчас невозможно найти в продаже такие модели, принципиально свежее 2017 года — поскольку их и нет в природе. На чем тогда остановились, то и производится — и продается. Улучшения не нужны? Даже точно возможные могли бы быть полезны части покупателей. Например, в стандартных корпусах остановились на 2 ТБ с SMR — сейчас в принципе реально «поднять» емкость таких моделей до 3 ТБ, либо освоить 2 ТБ без «черепицы». Но ни первое, ни второе не окупит затрат на разработку и внедрение — поскольку платежеспособный спрос сместился в сторону SSD. На фоне их производительности разница между SMR и не-SMR исчезающе мала. Да и сравнительно с тем количеством флэша, которое можно впихнуть в типичный корпус, что 2, что 3 ТБ — одно и тоже. Цены пока существенно различаются — поэтому многие покупатели готовы пойти на компромисс. Но их недостаточно, чтобы оплачивать прогресс в этой области. А он уже не может быть интенсивным: поскольку последняя «универсальная» инновация, позволившая радикально увеличить плотность хранения данных — перпендикулярная магнитная запись (PMR), внедрение которой к 2010 году было уже фактически закончено.

Следующий «большой скачок» по замыслам разработчиков должен быть связан с подогревом пластин при записи. Чистая физика — коэрцитивная сила напрямую зависит от температуры, так что при точечном нагреве для записи можно использовать слабые (и очень «локальные») магнитные поля, уменьшая и размер магнитных доменов. Чем он меньше — тем выше плотность записи. В общем, технология не эволюционная, а революционная — как и все предыдущие таковые, способная вывести накопители на жестких магнитных дисках на новый уровень. Вот только с ее освоением начались сложности — и буквально сразу.

Фактически с подогревом поверхности лазерным лучом в Seagate начали работать еще в 90-е годы прошлого века — когда в ходу были гигабайты или, в лучшем случае, десятки гигабайт емкости, получаемые при помощи продольной магнитной записи (LMR). Спустя несколько лет компания убедилась в перспективности подхода — так что еще в сентябре 2002 года все заинтересованные ознакомились с простым пресс-релизом:

3 сентября 2002 года — Из европейской штаб-квартиры компании Seagate в Париже (Франция) сообщают о решении Seagate использовать новую революционную технологию HAMR, которая позволит отодвинуть далеко в будущее так называемый «суперпарамагнитный» предел при записи данных на жесткий магнитный диск. Seagate продемонстрировала новую революционную технологию «магнитной записи с нагревом носителя» HAMR (Heat Assisted Magnetic Recording), которая позволяет записывать данные на высокостабильном магнитном носителе с применением теплового лазера. Новая технология была продемонстрирована в рамках торжественной церемонии открытия нового современного исследовательского центра Seagate общей площадью 18,6 тыс. кв. м. в Питтсбурге (Пенсильвания, США).

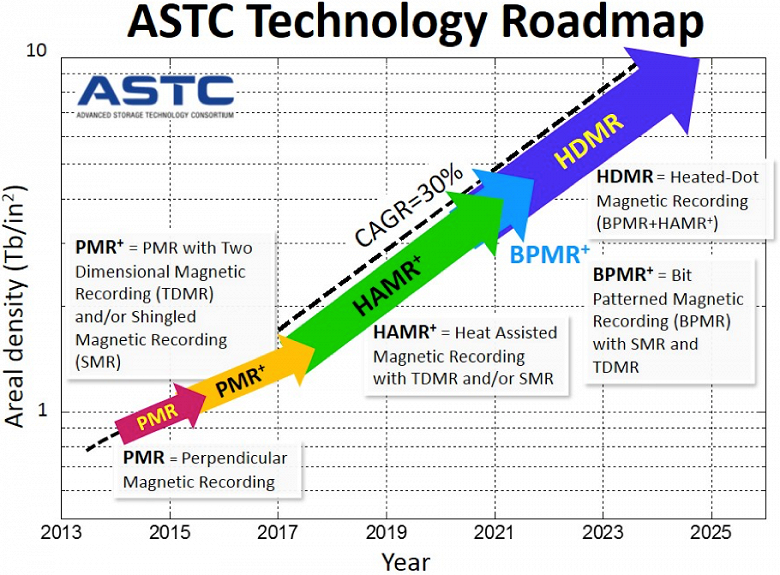

Позднее планы по использованию новой технологии были озвучены Fujitsu (тогда еще производителем жестких дисков, но сейчас уже ушедшим с рынка) и HGST (тогда еще независимым производителем, но сейчас уже растворившимся в WD). Разговор шел о внедрении в районе 2010—2013 года — т. е. сразу после окончания полного перехода на PMR. Последняя по замыслам производителя на квадратном дюйме могла позволить хранить не более одного терабита данных —, а HAMR должная была начаться сразу с четырех. В перспективе добраться и до 50—100 Тбит — т. е. получить те самые сотни терабайт емкости «десктопных» винчестеров и десятки — условно «ноутбучных».

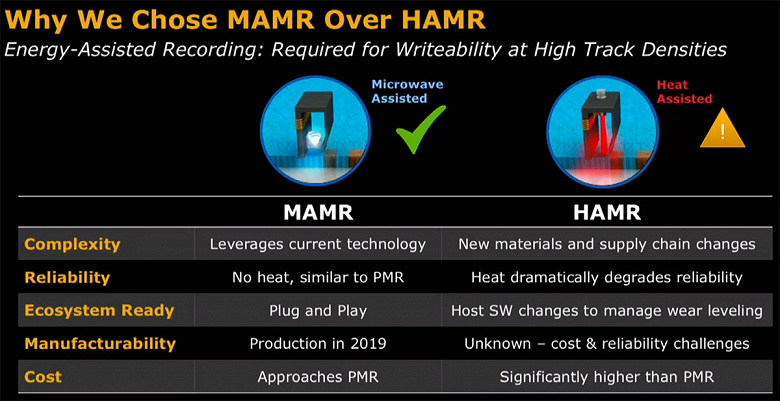

Шло время. Наступил 2010 год, а затем и 2013 — дисков мы так и не увидели. Вместо этого увидели наводнение в Таиланде, нанесшее сильный удар по производству, что вызвало дефицит всех моделей. В таких условиях было не до новых технологий — расхватывали и старые. Позднее ситуация относительно нормализовалась, но технология HAMR в отчетах Seagate начала напоминать горизонт — каждый год отодвигаясь на год вперед. В сложившихся условиях Toshiba и WD вообще заявили, что не стоит слишком привязываться к HAMR — пластины греть надо, но микроволновым излучением (MAMR). Появился еще один горизонт — также удаляющийся год за годом.

Недавно ожидание наконец-то кончилось — в феврале этого года Toshiba анонсировала диски серии MG09, использующие FC-MAMR (Flux Control Microwave Assisted Magnetic Recording), обещав начать их поставки с конца марта. В Seagate начали поставки первых дисков с HAMR в конце прошлого года —, но исключительно в составе собственных систем хранения Seagate Lyve. Но особого ажиотажа и то, и другое на деле не вызвало — поскольку всего 18 или 20 ТБ. «Обычные» серии дисков обе компании дотянули до 16 и 18 ТБ соответственно — т. е. выигрыш от «подогрева» пока недостаточен для того, чтобы все ринулись испытывать на себе новые технологии. Даже те компании (о физлицах тут и говорить не приходится), которым действительно нужно запихивать большие объемы информации в ограниченное пространство. Потребуется на петабайт 56 или 50 дисков — да какая, в общем-то, разница? Можно и 64 по 16 ТБ поставить — в проектировании СХД ничего принципиально не меняется. Поэтому на деле произошло все без особого шума — который решено отложить на перспективу. Например, в Seagate уверены, что емкость HAMR-дисков можно будет повышать каждый год не менее чем на 20%. Следовательно, в следующем году мы получим 24 ТБ — и вот они уже могут активно пойти даже в розницу. А через пару лет (поскольку «не менее») свет могут увидеть и модели на 30 ТБ. Потом — и больше. Так что положение на рынке изменится. Правда это уже совсем другой рынок — последнее десятилетие изменило его радикально.

Эволюция без революций и ее итоги

Как видим, в технологии жестких дисков произошел временной разрыв — по сути «подогрев» должен был начаться сразу после освоения PMR, однако вместо этого мы получили 10 лет безоговорочного господства этой технологии на рынке накопителей. Точнее, уже на сегменте рынка — если лет 10–15 назад после слова «накопитель» как правило можно было уверенно дописывать на жестких магнитных дисках, то теперь уже речь идет о полноценном сосуществовании «механических» (ну или «газовых» — вспоминая ключевой момент технологии: головка летит над поверхностью благодаря подъемной силе) и твердотельных накопителей. На деле обе технологии очень старые —, но не так уж далеки друг от друга по времени разработки. Первые жесткие диски появились в 1956 году, но первое устройство современной компоновки (т. е. с объединением в одном неразъемном корпусе и пластин, и головок чтения/записи) — это уже 1973 год. Первый в мире твердотельный накопитель появился в 1976 году, но использовал он DRAM — SSD на флэш-памяти дебютировали на рынке в 1988 году. Они уже тогда имели ряд преимуществ над «механикой», но о массовом применении говорить не приходилось — все портила очень высокая стоимость хранения единицы информации. Впрочем, когда-то этот фактор мешал и жестким дискам. Например, первый в мире HDD для персональных компьютеров, а именно Seagate ST-506 стоил $1700 — т. е. $340 за мегабайт, поскольку и всего их было пять. Упомянутый выше Digipro Flashdisk стоил $5000 —, но в относительном исчислении это даже чуть дешевле, чем ST-506, поскольку за такие деньги предлагалось уже 16 МБ. Правда и год на дворе был 1988, а не 1980 — тогда уже жесткие диски на 40+ МБ стали обычным делом для персоналок. Например, годом ранее дебютировало семейство IBM PS/2. Model 30 (фактически рестайлинг PC XT) стоила $2295 — включая как раз и винчестер на 20 МБ. Самая дорогая Model 80 тянула уже на $10995 — зато покупатель получал i386DX/20, целых 2 МБ ОЗУ и аж 115 МБ дискового пространства. Но в целом и те, и другие накопители пробивали одни и те же «ценовые» уровни — просто флэш начал это делать позже, а цены механических мегабайтов летели вниз ничуть не медленнее. Позднее гигабайтов. А от терабайтной отметки начались проблемы. Ставшие в конечном итоге нерешаемыми. В том плане, что флэш не может вытеснить механику — производства банально недостаточно, а наращивать его удается не быстрее роста потребностей. Но и вернуть все как было уже не получится — потребители распробовали новые технологии и их преимущества. Даже если разница в цене перестанет сокращаться и немного увеличится — запихнуть этого джина в бутылку уже не выйдет.

Почему его ранее получалось не выпускать? Потому, что жесткие диски «улучшались» быстро, в разных направлениях — и без особых сложностей. Действительно — что дает, например, увеличение плотности записи вдвое? Увеличение емкости вдвое — ответ простой, но не полный. Ведь увеличивается не только максимальная емкость —, но и минимальная. Которую обеспечивают самые простые и дешевые модели на одной пластине и с одной-двумя головками. А еще увеличивается скорость последовательных операций (по крайней мере): ведь за один оборот диска можно записать или прочитать вдвое больше данных. И то, и другое затрагивает все диски на рынке — что могут учитывать производители программного обеспечения. Windows 95 требовала наличия жесткого диска на 40 МБ — и это в 1995 году еще вызывало недовольное бухтение некоторых пользователей подустаревших к тому моменту компьютеров. Windows XP в 2002 отказывалась устанавливаться на разделы менее 1 ГБ —, но на это никто уже не обращал внимания. Все усвоили главное: что кажется чрезмерным сейчас, лет через пять станет смешным.

Кстати, в таких условиях сильно просели требования и к надежности дисков. Нет, конечно, незапланированный выход из строя любых компонентов ПК неприятен, а накопителей — вдвойне неприятен, поскольку именно они хранят информацию, но… Последнее решается резервным копированием. А трястись над устройством, которое радикально устаревает лет через пять, не имеет смысла. При таких темпах развития большинство жестких дисков на свалку отправлялось в исправном состоянии. Например, куплен в 2000 году винчестер на 20 ГБ — в 2005 этого стало не хватать, так что приобретен новый на 200 ГБ: и больше, и быстрее. Оставлять старый работать вместе с ним? Не за чем — это всего лишь +10% медленного дискового пространства. Продать? Когда в магазинах лежат диски от 100 ГБ, выручить за 20 можно лишь совсем незначительную сумму. Скорее, просто подарить — если есть кому. Или выбросить. А не дожил немного до плановой замены — да тоже невелика потеря (при условии, что данные сохранились): все равно остаточная стоимость нулевая.

Что мы изменилось за последние 10 лет? Да буквально все. Например, общая емкость — винчестеры на 1, 2 и 3 ТБ продаются до сих пор, хотя и последним уже те самые 10 лет стукнули. Да — сейчас это немного другие устройства, но потребительские характеристики за это время практически не улучшились. Следовательно, и старые продукты сохраняют актуальность — при наличии у пользователя. Кому-то, разумеется, уже не хватает их емкости или скорости. Но в первом случае речь о замене на новый диск обычно уже не идет — покупается еще один, причем зачастую сопоставимого «размера». Купить что-то в 10 раз большее можно (иногда — для 3 ТБ это уже вообще не выполняется), однако «по деньгам» это не слишком выгодно, поскольку такие модели стоят дороже (и в относительном исчислении — тоже), чем маломерки. А когда не хватает производительности — можно уже и поменять на SSD той же емкости. Либо (что экономически более выгодно) SSD небольшой емкости тоже докупается к имеющемуся жесткому диску. Т. е. в современных условиях, когда емкость растет очень медленно, а скорость уже не важна, на первое место вообще выходит срок службы.

Почему так произошло? Потому, что плотность записи практически не росла — как уже было сказано выше. При этом максимальная емкость жестких дисков все-таки выросла за десятилетие примерно на порядок —, но титаническими усилиями производителей и не бесплатно. Лишь часть этого пришлась на увеличение продольной плотности записи — полезной со всех точек зрения. Правда достигалось это не какими-то серьезными инновациями, а «вылизыванием» технологии. Поэтому в отличие от прошлого новые «высокоплотные» пластины не имеет смысла применять во всех моделях — это не окупится. Уже освоив 1 ТБ на пластину, многие производители продолжали штамповать 2—4 ТБ на пластинах по 800 ГБ — так дешевле получалось. Хотя потребители предпочли бы меньшее количество «больших» пластин —, но не за большие деньги. Сейчас проблема только усугубилась.

Жертвы прогресса

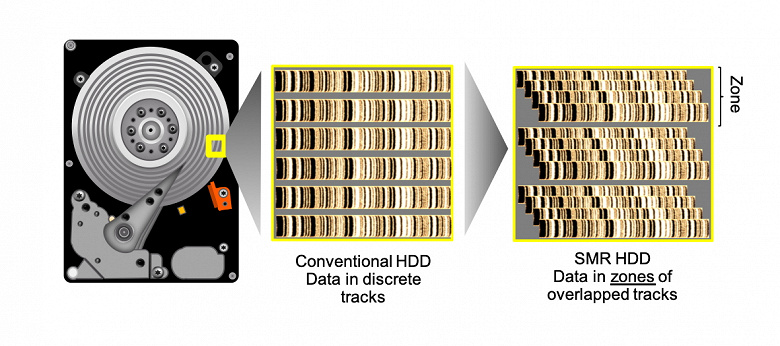

Что делать, когда делать нечего? Попробовать поиграть с поперечной плотностью записи (т. е. количеством дорожек) — либо с количеством дисков в пакете. Звучит просто и красиво — на практике приводит к разным неожиданным эффектам. Например, самые простой и дешевый способ увеличения количества дорожек — повыкидывать часть зазоров между ними. А чтоб избежать проблем с взаимным влиянием дорожек друг на друга, записывать их будем сразу несколько — широкой лентой. При этом записывающая головка может быть мощной и относительно грубой, так что недорогой. Считывающая — тоже недорогой и простой. Получаем бесплатное увеличение емкости пластины на 20%—30% — все довольны. Пока не выясняется, что «бесплатность» была исключительно в денежном эквиваленте — да и то в основном для производителя. А вот пользователи от «черепичной записи» (а это именно она — SMR) получают массу проблем, о которых никто никогда не задумывался. «Нормальный» диск может в любой момент времени взять и записать любой сектор — SMR так не может, поскольку операция будет влиять на соседние секторы. Поэтому на пустом диске все хорошо — ведь мы только записываем информацию, не трогая уже хранимую. А вот по мере эксплуатации будут возникать неожиданные просадки производительности. Просто потому, что в обычных системах используется Drive-Managed SMR — т. е. система не в курсе, что ей подсунули, а диск пытается эмулировать «обычный». Host Managed SMR серверных моделей куда предсказуемее, но для ее использования требуется «перелопачивать» всю инфраструктуру.

Поэтому и DM-SMR — производителям нужны были недорогие диски, которые можно устанавливать в обычные системы. А чтобы нивелировать отрицательные эффекты технологии, «внутреннюю кухню» начали усложнять. Например, внедрив медиакэш — совокупность CMR-дорожек, флэш-памяти и DRAM, которая должна «перехватывать» интенсивные обращения к диску. Особенно те, которые и классическим-то винчестерам не нравятся — с произвольной адресацией. А дальше в момент простоя диск информацию из кэша разгребет по лентам. Во всяком случае, так задумано. Но не всегда получается на практике. Где, например, кэша может не хватить для завершения «сеанса» повышенной активности — так что накопитель полностью уйдет в себя, расчищая место. И либо вообще не будет реагировать на запросы хост-системы, либо будет переваривать их очень медленно. В обоих случаях может быть попросту отключен по таймауту — так ведут себя некоторые RAID-контроллеры. В обычном ПК, скорее всего, рано или поздно придет в себя… Изрядно напугав пользователя и добавив ему волнений —, а то и седых волос, если вдруг покажется, что «накрылся» диск с важной информацией в единственной копии.

Хотя в принципе SMR — полезная технология, поскольку стоимость хранения данных она снижает, а при правильном использовании — никому не мешает. Но при правильном — и осознанном. Недавний скандал вокруг технологии относился не к ней самой —, а к сокрытию информации. Производители в старых и проверенных линейках некоторые старые и проверенные модели поменяли на новые SMR — и никому об этом не сказали. При том, что технология, в общем-то, новой сама по себе считаться не может — первые жесткие диски с использованием SMR появились на рынке еще в 2014 году, так что специалисты все нюансы давно изучили. А ныне «выжившие» ноутбучные винчестеры — это, как уже сказано, в основном модели года так 2017. И с тотальным использованием SMR — ничего другого на 1—2 ТБ давно уже практически невозможно купить (на самом деле 2 ТБ в корпусах толщиной 7 мм без SMR и вовсе никогда не существовало). Но одно дело — отдельные ниши, причем без вариантов. Другое — когда какой-нибудь WD Red на 2—4 ТБ был «обычным», а стал SMR. При этом в номере модели поменялась одна буковка — чего, естественно, основная целевая аудитория таких накопителей не заметила. Привлекли бы к этому внимание в явной форме сразу — заметила бы. И сделала бы выводы — те или иные. Кому-то новые модели подходят не хуже старых, кому-то стоило поискать что-то дороже, но без таких особенностей. Однако, подобные вещи происходят тихо — жди скандала. Он и случился.

Хорошо —, но дорого

SMR — не единственное изобретение последнего времени, и не единственная технология, позволяющая повысить емкость пластин. Но из всех таких она единственная, позволяющая сделать это бесплатно «в деньгах» — пусть и с нюансами по производительности. Поэтому активно применяется в недорогих жестких дисках, но практически отсутствует в топовых моделях (за исключением некоторых серверных с HM-SMR — что совсем другая история). Их делают совсем по-другому.

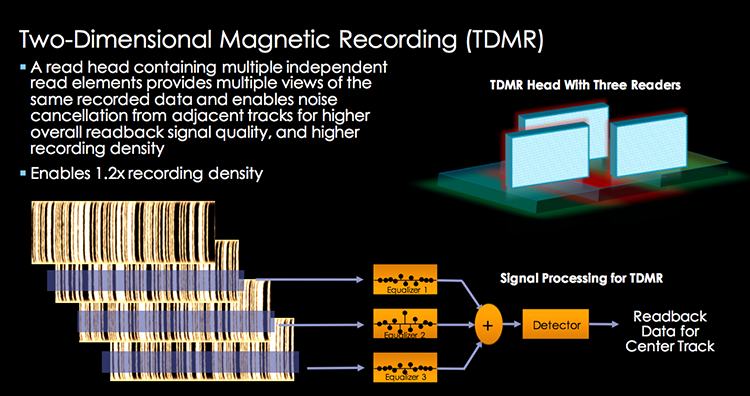

Для увеличения плотности хранения информации ныне используется технология двухмерной магнитной записи (TDMR). Суть ее в том, что пишущие головки здесь тоже «узкие», так что большое количество дорожек помещается на магнитный «блин» без перекрытия. Возникающая же проблема взаимной интерференции сигналов с разных дорожек при чтении решается использованием сразу двух (а то и трех) «считывателей» в головке чтения, смещенных относительно друг друга, с последующим анализом полученных данных. Побочным (относительно увеличения емкости пластины на 10%—15%) эффектом TDMR является потенциальное увеличение скорости чтения данных: если, например, мы считали данные сразу с двух дорожек (цилиндров) и «рассортировали» их в кэш-памяти, а потом оказалось, что это один большой массив данных, последовательно на них и расположенный… на этом можно и остановиться, вместо обычного «последовательного» чтения дорожки за дорожкой. Понятно, что такие идеальные случаи будут возникать далеко не всегда, а при чтении небольших файлов — и вовсе никогда, но иногда такой эффект получить тоже можно будет и на практике.

Казалось бы, все хорошо. Пока не задумаешься о стоимости — применение TDMR удваивает-утраивает количество считывателей и требует использования сложных схем анализа информации. Полупроводниковой продукции свойственно постоянно дешеветь (на длинных дистанциях), но, естественно, при прочих равных «классика» всегда дешевле — меньше элементов, меньше работы. Поэтому TDMR применяется лишь там, где без нее обойтись нельзя. Хотя сейчас технология позволяет уже получать 2 ТБ с пластины, а это могло бы дать нам диски на 4—6 ТБ всего на 2—3 «новых» пластинах», но стоить это будет дороже, чем 4–5 «старых» пластин и «простые» головки. В отличие от того, повторимся, что творилось на рынке три десятилетия подряд — когда увеличение продольной плотности быстро делало невыгодным выпуск пластин и головок по старым технологиям во всем модельном ряду. Сейчас же такие «апгрейды» стали точечными. Например, Seagate освоил пластины по 2 ТБ в семействе Exos X18 — и постепенно перевел на них модели на 14 и 16 ТБ, что позволило уменьшить количество пластин на одну. А вот 12 ТБ так и остались на предыдущем дизайне — с семью пластинами. Впрочем, изначально в этих моделях было восемь «блинов» —, но вот сокращать их количество до шести пока не стали, хотя уже и можно. Кроме того, такие пластины и головы используются в «воздушных» моделях на 10 ТБ — поскольку без них такие попросту невозможны. И, опять же, никто не стал редизайнить предыдущие «атмосферники» на 8 ТБ — в них выгоднее продолжать использовать пять «блинов» предыдущего поколения.

Сами по себе разные газовые среды — тоже в основном достижение последнего десятилетия: первые гелиевые HGST Ultrastar He6 появились на рынке в 2013 году. Несмотря на это, отношение к данной технологии остается настороженным у многих пользователей… да и у производителей — тоже: HGST в качестве экспериментов начала внедрение с 6 ТБ, но большинство стартовало только с 10+ ТБ. Причины такого отношения — разные, но сходятся в одном: никто не желает переплачивать. Гелиевые диски по определению дороже воздушных. Но обойтись без них в современном мире уже нельзя.

Просто потому, что емкость можно наращивать не только интенсивными методами (увеличением плотности записи), но и экстенсивным увеличением количества пластин. Первое время этот процесс был легким и относительно безболезненным — когда-то уважение вызывали модели на трех блинах, но за быстрое время все производители освоили и пять. Дальше — тупик. Головка должна лететь на определенной ненулевой высоте над поверхностью. Плюс ее размеры — значит между дисками должен быть определенный промежуток, куда помещаются, не мешая друг другу две головки. Плюс толщина самих пластин — в итоге пакет дисков имеет определенную минимальную высоту, уменьшить которую уже нельзя. Можно увеличить толщину дисков. Но не нужно — в удвоенный по высоте отсек можно просто поставить два винчестера.

Почему гелий? Выше текучесть — так что меньше подъемная сила и ниже турбулентность. А это значит, что головки могут летать ниже. Зазор между дисками сокращается — в тот же корпус можно «впихнуть» больше пластин. На сколько? На данный момент в полтора-два раза: старшие гелиевые модели построены на девяти «блинах», а «атмосферники» — максимум на шести, но производители стараются по возможности ограничиваться пятью (для надежности и относительной простоты изготовления). В итоге разная емкость — как уже сказано, у Seagate, например, 10 и 18 ТБ. При этом приятным побочным эффектом является снижение энергопотребления — пластины в гелиевой среде тоже слабее «тормозятся», так что меньше энергии уходит на поддержание постоянной скорости их вращения.

Это плюсы. Теперь минусы — тесно связанные с плюсами. Гелий — текуч, так что может и вытечь. Чего, собственно, некоторые пользователи и боятся. Производители, впрочем, утверждают, что, буде такое произойдет, головки взлетят выше, начнутся проблемы с записью —, но все старые данные можно будет спокойно прочесть. Но сама перспектива многих пугает — раз уж в современных условиях диски остаются актуальными и по 10 лет, не хотелось бы выбрасывать их через пять. С другой стороны, как уже сказано, технология на рынке уже восемь лет — и пока никаких массовых проблем не отмечено.

Однако в любом случае конструктивно это совсем другие диски — даже внешне сложно спутать гелиевую модель с «воздушной». Глухие корпуса требуют специальных технологий изготовления, других материалов — и обходятся в производстве намного дороже. Внутри тоже сэкономить не на чем — гелий допускает существование девяти «блинов» в пакете, но не делает создание таких моделей простым и дешевым: все допуски здесь намного жестче, чем в винчестерах на меньшем количестве пластин. Поэтому по цене одного диска на 16—18 ТБ иногда можно приобрести три «воздушки» по 8 ТБ — и получить в полтора раза большую емкость. Но уйдет на это втрое больше отсеков — почему и невозможно обойтись без гелия там, где речь заходит о петабайтах емкости. И без HAMR/MAMR там тоже в ближайшем будущем обходиться не будут — потому что уже не могут.

Что же касается простого ендъюзера, то ему все эти навороты… не нужны. Будь на рынке простые и относительно недорогие винчестеры на 50 ТБ — некоторые потребители нашли бы им применение, но большинство в таком случае все равно спокойно обходилось бы и 10 ТБ или даже меньшими объемами: лишь бы дешевле. Но сейчас нет не только дешевых 50 ТБ — на деле и дешевых «десяток» тоже нет. Поэтому выбирают накопители все «танцуя от бюджета» — приходя нередко к тем самым 1—3 ТБ до сих пор. Если мало — то рассматриваются винчестеры большей емкости, но в 146% случаев только «воздушные» и, обычно, даже в этих семействах предтоповые. Т. е. когда «на воздухе» получалось 8 ТБ, самыми дешевыми в пересчете на стоимость терабайта оказывались модели на 2–6 ТБ («единички» все-таки давно хороши лишь минимальной абсолютной ценой) —, а сейчас уже фокус можно смещать на 3–8 ТБ. Да и все, пожалуй. Выше — своя атмосфера. Очень важная и нужная — даже тем, кто об этом не знает, а просто заливает фоточки в облако. Но это уже другая история.

Итого

История персональных компьютеров начиналась с флопи-дисководов в лучшем случае — рассчитанные на бытовое применение модели зачастую обходились и сопряжением с бытовым же кассетным магнитофоном. Прошло немногим более десятилетия — и жесткий диск стал обязательным компонентом, без которого нормальное использование современного (на тот момент) программного обеспечением перестало быть возможным. Еще десять лет — и на рубеже веков начался бурный расцвет: винчестеры постепенно хоронили одну за другой все технологии, с которыми конкурировали или «сотрудничали» на предыдущих этапах. Продажи компьютеров постоянно росли. Некоторые новые пользователи в итоге и не знали о том, что когда-то емкость этих устройств измерялась даже не в гигабайтах, а в мегабайтах — к концу «нулевых» дошли уже до терабайтов (хотя, повторимся, за 30 лет до этого в массовом сегменте начинали с нуля). Будущее казалось простым, безоблачным — и распланированным на много лет вперед.

Единственное, что из тех прогнозов исполнилось — жесткие диски и сейчас являются основным носителем информации в целом, а их емкость продолжает расти. Но совсем другими темпами, нежели ранее — и, можно сказать, на других принципах. Некогда улучшения технологии производства пластин и головок позволяли интенсивно наращивать плотность записи, практически не меняя конструкцию самого устройства. Просто и ее иногда по возможности улучшая: так количество пластин в пакете при сохранении размеров, сложившихся еще в 90-е, выросло, да и скорость их вращения почти удвоилась. Нельзя сказать, что это обходилось бесплатно —, но все затраты на разработку и внедрение быстро окупались. Новые диски оказывались настолько лучше старых (и по емкости, и по скорости), что использование вторых быстро теряло смысл — иногда даже быстрее, чем кончался гарантийный срок. Да и рынок тогда рос — и ему требовалось каждый год все большее количество накопителей. Поскольку хотя бы один винчестер был в каждом продаваемом компьютере. И кроме него в большинстве таковых ничего и не было.

Однако прошлое десятилетие поменяло все. Во-первых, рост продаж компьютеров прекратился — появились альтернативные умные устройства. Во-вторых, и во многих компьютерах жестких дисков больше нет. Причем быстрее всего этот процесс шел в ноутбуках — которые лет 10 назад и обеспечивали основной объем продаж. Потребность в емких «стационарных» (поскольку «десктопными» их назвать уже сложно)

Полный текст статьи читайте на iXBT